Alors que les tests de QI traditionnels sont conçus pour mesurer l'intelligence humaine dans des domaines tels que le raisonnement logique, la résolution de problèmes et les compétences verbales, ils ne sont pas adaptés aux modèles de langage de grande taille (LLM). Les LLM ne sont pas des entités cognitives ; ce sont des systèmes sophistiqués de reconnaissance de motifs entraînés sur de vastes quantités de données pour prédire des séquences de langage.

Contrairement aux humains, les LLM ne “pensent” ni ne “raisonnent” de la même manière, et ils n'ont pas de capacités intrinsèques de résolution de problèmes. Leurs résultats sont basés uniquement sur des corrélations statistiques, plutôt que sur une compréhension ou une intention.

Bien que l'IA ne puisse pas être comparée directement aux humains, on peut au moins mesurer les LLM les uns par rapport aux autres.

C'est l'approche adoptée par le Chatbot Arena Classement

Le Chatbot Arena Classement

Le Chatbot Arena est une plateforme conçue pour comparer et classer des modèles de langage en permettant aux utilisateurs d'opposer directement deux modèles dans des compétitions. Les utilisateurs saisissent un prompt et les deux modèles génèrent des réponses, l'utilisateur choisissant la meilleure. Les résultats sont agrégés à l'aide du système de notation Elo.

Le classement comprend des modèles propriétaires comme GPT-4 d'OpenAI et Claude d'Anthropic, ainsi que des modèles open-source comme Mixtral et LLaMA.

Les différences de score Elo soulèvent des questions sur leur pertinence réelle. 1338ㅤ, Gemini-1.5-Pro-002 at 1304ㅤ, Meta-Llama-3.1-405b-Instruct-bf16 at 1257 et Mixtral-8x22b-Instruct-v0.1 1148.

Félicitations à ChatGPT, mais devrions-nous vraiment nous soucier des différences de score Elo ?

Quelle est la signification d'une différence Elo ?

Tout d'abord, nous devons comprendre la signification d'une différence de notation Elo. La formule utilisée est : chances de gagner = 1 / (1 + 10^(différence de notation / 400)).

- Une différence Elo de 70 points signifie qu'un modèle a 60 % de chances de mieux performer, ce qui est 10 % au-dessus de la moyenne, laissant 40 % de chances de ne pas surpasser l'autre.

- Une différence de 100 points se traduit par 64 % de chances de mieux performer, soit 14 % au-dessus de la moyenne.

- Une différence de 200 points implique 76 % de chances d'être meilleur, soit 26 % au-dessus de la moyenne.

Gardez cette échelle à l'esprit lors de la comparaison des classements.

Avertissement

Chez SynapseDX, notre mission est de transformer la façon dont les entreprises gèrent leurs opérations en intégrant harmonieusement l'intelligence artificielle (IA) à leurs systèmes actuels.

Notre objectif est de se concentrer sur des cas d'utilisation qui améliorent l'efficacité opérationnelle, la compréhension du contexte et l'acheminement des décisions.

Nous évitons des fonctionnalités comme la génération de contenu créatif, la génération de code et le débogage, ou les conversations semblables à celles des humains. Nous nous concentrons sur des applications pratiques et spécifiques de l'IA qui génèrent de la valeur.

Notre défi est d'identifier quel LLM est le plus rentable pour les tâches spécifiques que nous lui assignons. Par conséquent, notre approche et nos conclusions peuvent ne pas s'appliquer à vos cas d'entreprise.

Réflexions initiales

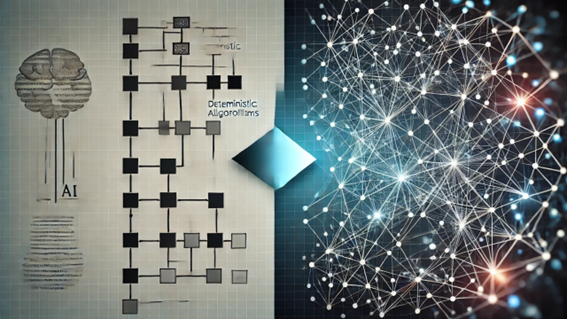

Classements ELO offre un aperçu utile de force relative, mais ils ne peuvent pas pleinement compte pour chaque IAs forces et les faiblesses.

Réponse Un peut être mieux que la réponse de B, mais cela ne signifie pas que B est une mauvaise. Par exemple, si je demande un résumé d'un texte, la perte de la réponse peut toujours être exactes.

Tout en ELO identifie le plus fort, il ne reflète pas nécessairement qui est le mieux adapté ou surqualifiés pour une tâche particulière.

ELO évolue dans le même modèle

Exemples:

- ChatGPT-4o modèles ont connu un 74-une augmentation d'un point dans leur classement Elo au fil du temps.

- ChatGPT-4 modèles ont vu une 88-gain.

Il est notable de la variation entre les différentes versions d'un même modèle.

L'Impact de l'Invite

Ici, nous considérons l'impact de l'invite sur la qualité de la réponse. Un facteur clé que nous avons identifié est la complexité de la question posée.

Dans nos tests internes, nous avons fourni ChatGPT-4 avec un texte et a ensuite demandé à la même 5 questions de deux façons différentes:

- Tout à la fois

- Un à la fois

Les questions étaient fermées, il n'y a pas de “meilleure” réponse n'est correcte ou incorrecte ceux. Nous avons considéré l'ensemble de la réponse correcte uniquement si toutes les réponses sont correctes.

La comparaison entre les poser 5 questions individuelles, plutôt que d'utiliser une invite unique contenant tous les 5 questions a montré une différence de performance de plus de 200 Points Elo.

Ce test à petite échelle est appuyée par plusieurs études, dont une par Subbarao Kambhapati de l'équipe, qui met en lumière la façon dont le programme de MAÎTRISE de la performance tend à se dégrader que le problème de la complexité augmente.

Convertis dans les classements Elo, les performances chutent traduire par une diminution de 100 à 150 points Elo lors de la manipulation de problèmes avec cinq niveaux de profondeur, et plus de 400 Points Elo avec un 10 niveaux de profondeur.

Conclusion

Gardez à l'esprit que le fait de poser une question à la fois d'améliorer les performances de plus de 200 Points ELO. Donc:

- Maintenir en un seul point

- Cible de précision

- Éviter toute ambiguïté

L'effet concret de l'application de cette méthode, c'est que vous pourrait potentiellement réduire l'échelle de la propriété champion ChatGPT-4o (1338 ELO) pour Apache 2 sous licence, auto-hébergé, léger Mixtral-8x22b-Instruire (1148 ELO).

BonusCette approche améliore également la vérifiabilité, comme fine des réponses, il est plus facile de repérer où des erreurs se produisent.

Tout le monde jouit d'une bonne concurrence, mais le véritable enjeu est au-delà de la 34-point de différence entre ChatGPT et Gemini. En fin de compte, l'impact de l'homme reste prédominante.